L’AI di Meta messa sotto stress non riesce a concepire fuori da uno schema che rasenta il razzismo. E mostra i limiti umani più che i suoi.

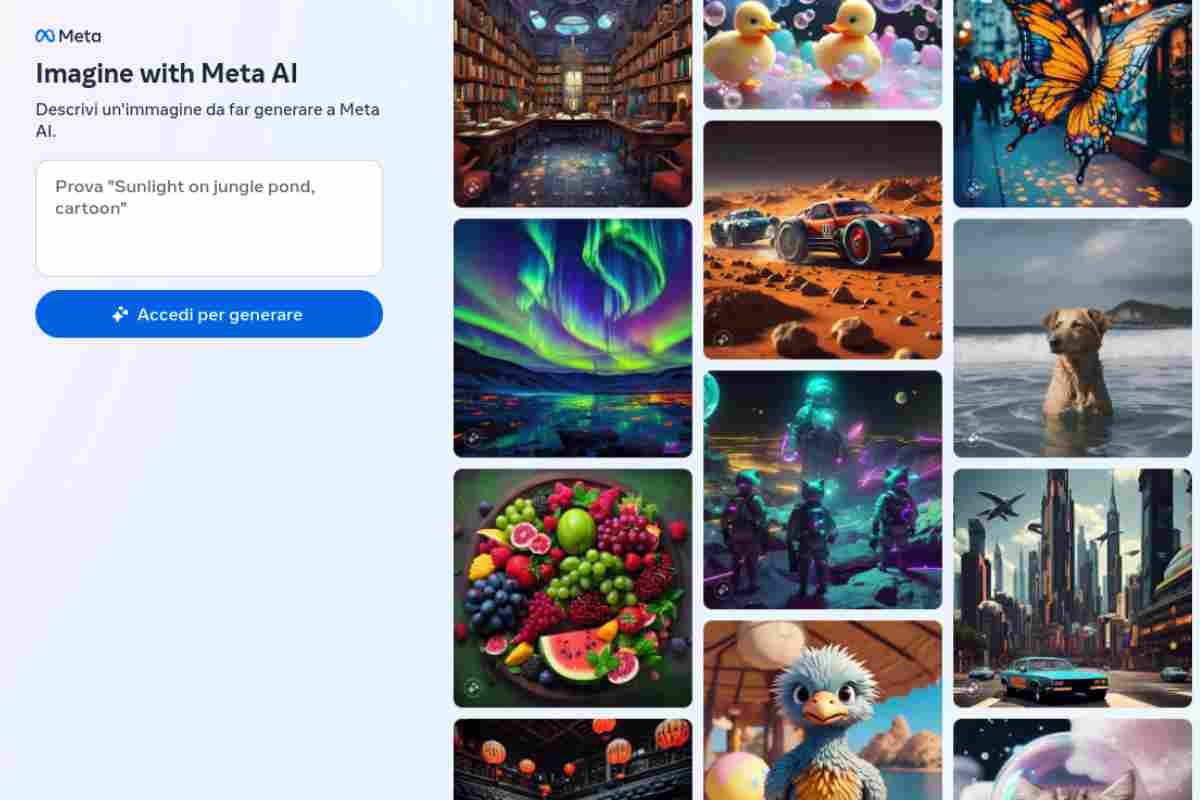

Le intelligenze artificiali sembrano vive. Ma un esperimento che i colleghi di The Verge hanno portato avanti mostra tutti i limiti che per esempio ci sono ancora quando si prova a chiedere ad una AI di produrre un certo tipo di immagini.

Stavolta al centro dell’esperimento, che possiamo tranquillamente dichiarare fallito, la AI di Meta che si è dimostrata decisamente non di larghe vedute e anche un po’ razzista, nonché piena di una serie di stereotipi decisamente raccapriccianti.

Quello che si vede in superficie è un modello di generazione delle immagini che semplicemente non sembra avere troppa fantasia ma, trattandosi di un modello costruito da esseri umani, le falle nella generazione delle immagini riflettono non tanto un limite dell’oggetto tecnologico quanto un problema culturale di chi quell’oggetto tecnologico l’ha messo insieme.

La AI Meta non riesce a essere creativa

L’esperimento di Mila Sato di The Verge ha messo a dura prova le capacità creative della AI Meta. In particolare è emerso che l’intelligenza artificiale dell’ecosistema di cui fanno parte Facebook e Instagram non riesce a concepire coppie miste né riesce a concepire un essere umano dai tratti asiatici con qualcuno che non sia a sua volta della stessa etnia.

Non è servito, racconta Sato, modificare un po’ il prompt: il risultato è finito sempre con l’essere lo stesso. Chiedendo all’intelligenza artificiale di produrre un’immagine in cui ci fosse una persona asiatica insieme a un compagno o a una compagna dai tratti caucasici le immagini finivano sempre col mostrare una coppia di persone palesemente asiatiche. Allo stesso modo, all’inizio, la AI di Meta non è riuscita a concepire un’immagine in cui fossero presenti una persona asiatica con un amico oppure una amica dalla pelle scura.

Ma, prosegue la disamina di Sato, in questo caso specificando un po’ di più e sostituendo quindi un generico “Black” con un “African American” l’intelligenza artificiale è sembrato comprendere quello che si voleva da lei. E l’impossibilità dell’intelligenza artificiale di Meta di concepire le coppie miste non è forse neanche il bias più preoccupante. Perché dire persona asiatica non significa necessariamente dire persona di origine cinese o giapponese (come le immagini prodotte dalla AI invece fanno). Fanno parte del gruppo delle etnie asiatiche, per esempio, indiani, pakistani, abitanti dell’isola di Burma, nepalesi. Eppure chiedendo alla AI di Meta persone asiatiche tutto quello che l’intelligenza artificiale è riuscita a produrre è stato qualcuno che forse poteva sembrare cinese o forse poteva sembrare giapponese, in alcuni casi con un mix di culture da Oscar.

Questo però non ci dice solo che lo strumento dell’intelligenza artificiale generativa delle immagini ha un problema. Ci dice che chi ha progettato e ha dato da mangiare le immagini di partenza a questa intelligenza artificiale soffre di quegli stessi bias cognitivi. In generale quindi traiamo anche noi una conclusione simile a Sato. Gli strumenti di intelligenza artificiale, che entrano ed entreranno sempre di più anche nella produzione per l’intrattenimento e i videogiochi, vengono descritti come nuovi strumenti per ampliare la creatività degli esseri umani (quando non vengono utilizzati per sostituirla in toto) ma non possono andare di là di quello che gli è stato insegnato a fare. Questa non è creatività: è solo un altro modo di fare un riassunto.